データセンターの基本構造および電力消費に与える影響【RMFOCUS 第96号】

RM NAVI会員(登録無料)のみ全文閲覧できます

RM NAVI会員(登録無料)のみ全文閲覧できます

[このレポートを書いた専門家]

- 会社名

- MS&ADインターリスク総研株式会社

- 部署名

- 基礎研究部 受託調査グループ

- 執筆者名

- シニア研究員 酒見 友康 Tomoyasu Sakami

2026.1.5

- データセンターはサーバー等の情報通信機器を集中して設置・運用する施設で、日本での起源は電話交換局や企業の電算センターであるとされる。24時間365日、途切れることのないサービスを提供するため、極めて高い可用性、冗長性が求められる。

- データセンターの建物は高い耐荷重・耐震・免震や万全なセキュリティが求められ、サーバールーム、受電設備、UPS(無停電電源装置)、非常用発電機、冷却装置(空冷・水冷)や通信設備で構成される。

- 近年は生成AIの普及などに伴い、ラックあたりの消費電力が大幅に増加し、発熱対策や電力確保が課題となっている。水冷方式による冷却が省電力対策として注目される。データセンターの電力需要は特定地域に集中しやすく、需要増が電力供給や料金に影響を与える可能性も懸念される。

- 政策面では地方分散(ワット・ビット連携)、REIT(不動産投資信託)への組入促進、省エネ基準の導入が進められ、技術革新や蓄電・地産地消で効率化を図る取り組みの動向が今後の焦点となる。

1. データセンターとは何か

(1) 日本データセンター協会(JDCC)による定義

日本データセンター協会(JDCC; Japan Data Center Council)の「データセンター セキュリティ ガイドブック(2017年版)」によれば、データセンターとは、サーバー、ネットワーク機器、ストレージ等の情報通信機器を設置・運用することに特化した建物と設備の総称であり、これらを用いて提供されるサービスを指す場合もある。

(2) 日本におけるデータセンターの起源

① 電話交換局

電話用設備を置く目的で、逓信省(当時)は1890年に電話交換局を開設した。電話交換局は1952年に日本電信電話公社(電電公社、現NTT)へ引き継がれ、1953年からは国内通信向けを同社、国際通信向けは国際電信電話(現KDDI)が中心となって運用するようになった。

電電公社は1967年にデータ通信本部を設置し、1968年には地方銀行向けの為替交換システム(地銀協システム)を稼働させた。1980年代には電話交換機のデジタル化やシステム統合により、電話交換機を設置していた電算室のフロアに余剰スペースが生じ、これを通信機器等の設置場所として他社に貸し出すようになった。この経緯は、現在のデータセンターの源流の一つとみなされている。

② 電算センター(コンピューターセンター)

もう一つの起源は、1960年代以降に金融機関など大手企業が設置した大型汎用コンピューター(メインフレーム)用の電算センターである。メインフレームは大型かつ重量もあり、特殊な電源と冷却設備を必要としたため、一般オフィスに設置することは難しく、専用施設として電算センターが整備されたのである。

2. データセンターの構造

(1) 建物

データセンターには堅牢性、災害発生時においても被害を最小化する構造、さらに万全なセキュリティが求められる。内部はサーバールームを中心に、電源、通信、空調設備機器等が配置される。

図1のとおり、外壁に施設名称等の表示はなく、窓の少ない無機質な外観となっている場合が多い。窓が少ないのはセキュリティ上の理由もあるが、建物内の温度変化を抑え、空調効率を高めるためでもある。データの盗難を防ぐ目的から外壁に電磁シールドが備えられている場合もある。

不審者が侵入した場合に備え、建物内部にフロア図はなく、エレベーター内や各室の入り口にも室内の設備機器を説明するような表示はない。

① 床の耐荷重

データセンター建物の特徴の一つは、床の高い耐荷重である。一般的なオフィスの場合には1m2あたり300~500kgの重量に耐えられれば十分であり、最先端のオフィスビルの場合でも、建物全体として1m2あたり500kgくらいを基準としたうえで、重荷重エリアを局所的に強化する程度である。

一方、データセンターの場合には、サーバーラックにできるだけ多くのサーバーを収容しようとするため、ラック単体(150kg)とそこに収容するサーバー(30kg×20台)の重量の合計は750kgに達する。サーバーラックの設置面積は0.72m2程度であり、単位面積あたりでは約1,040kg/m2の耐荷重が必要である。最近では1m2あたり1,500kg以上が標準になっているようである。

② 天井の高さ・耐荷重

データセンターの各フロアの天井は一般的なビルよりも高く作られている。これは、ラック上への照明・消火設備の配置、および空調のための空気循環スペース確保のためである。

また、配管・ケーブル等を支持するため、フロアとフロアを仕切るコンクリートは厚くなっている。一般的なビルの場合には1階分の高さは3m程度であるが、データセンターの場合には5m程度である。このため、同じ階数であれば他用途の建物よりもデータセンターの方が高くなる。

③耐震構造・免震構造

そもそも活断層があるような場所への立地は避けるとともに、液状化の可能性がある地域では硬い地層まで杭を打ち込むなどの対策がとられている。建築基準法上、データセンターはその用途や規模から特殊建築物に該当する可能性が高く、厳格な耐震設計や構造計算が求められる場合が多い。

免震構造は建築基準法の必須要件ではないが、IT機器は瞬発的な地震の衝撃に弱いため、データセンター事業者の判断により免震構造を採用するケースも多い。

一定のフロア以上を免震構造にするケースや、フロアの一部エリアまたはラック単体レベルで対策を講ずるケースもあるが、建物全体を免震装置の上に載せる方式が一般的である。

免震装置の上にある建物は地震の際にゆっくり揺れながら衝撃を吸収し、水平方向に数十センチ程度動く構造になっている。

(2) サーバールーム

データセンターの主要な装置はサーバーであり、サーバーを収納する部屋がサーバールームである(図2)。ここには、ラックが整然と並び、冷却装置、監視カメラなどが設置され、人の出入りの少ない無機質な空間である。

サーバーはOSやソフトウェアを搭載しており、ネットワークを通じた外部からのリクエストに応じ、情報やデータ、サービスを提供する。

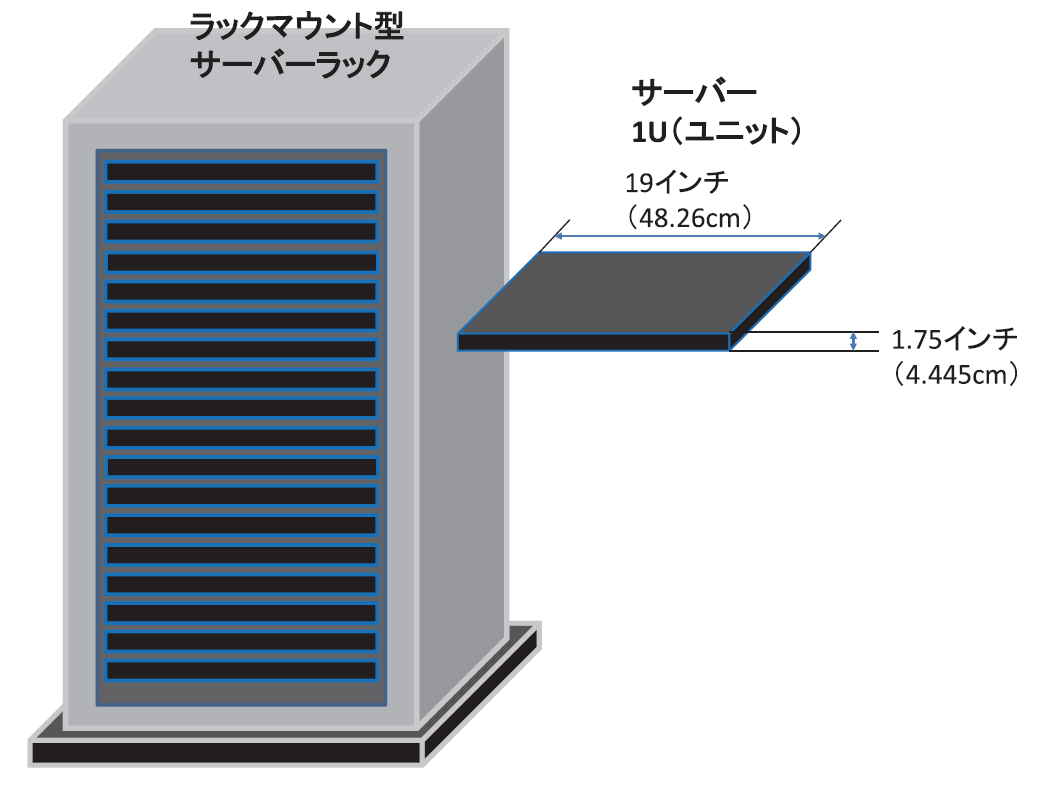

サーバーは「ラックマウント型サーバー」と呼ばれる専用ラック(図3)が一般的に使用されている。代表的なラックのサイズは高さ2,200mm、幅600mm、奥行き1,200mmで、横幅19インチ(48.26cm)のサーバーを収容できる。サーバーの横幅は均一であるが、高さは機種によって異なる。最も薄型のサーバーは高さが1U(ユニット)で4.445cmとなっており、それ以上の場合には、2U、3U、というようにUの整数倍で高くなる。

各サーバーにはCPU(中央処理装置)が搭載されており、計算処理の際にCPUが熱を持ち始めるとサーバーの前面に配置されたファンが作動し、その熱を背面に排出する構造になっている。

(3) 電源設備

① 受電設備、変圧器、分電盤

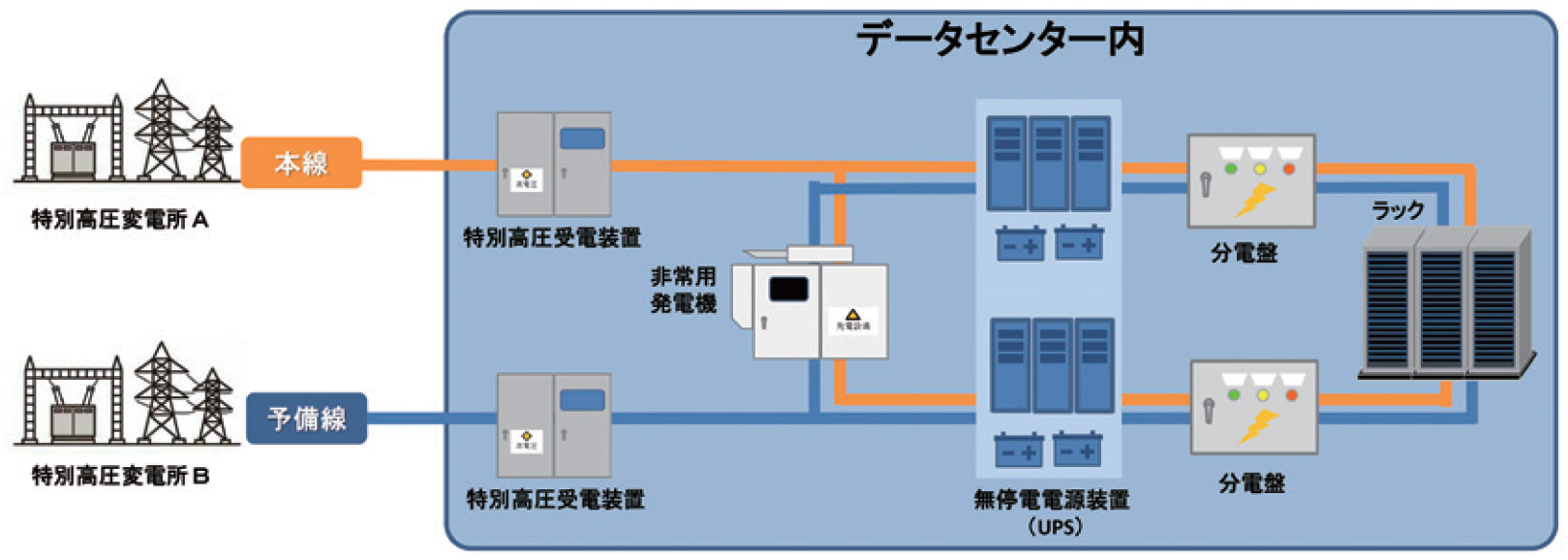

データセンターは大量の電力を消費するため、多くの場合、電力会社から標準電圧6万V(ボルト)以上の「特別高圧」で受電する。電力会社の配電線から施設内へ電力を引き込む受電設備、「特別高圧」電力の電圧を下げるための変電設備、さらに施設内の各機器まで送電するための分電盤が必要となる。

電力供給は冗長化が基本であり、電源を2系統から取ることが基本である。受電に際しても、異なる二つの変電所から本線と予備線による異系統2回線受電が採用され、立地条件などで制約がある場合には、同一の変電所から本線と予備線による同系統2回線受電方式が採用される。

サーバールームのラックまで送電する際においても、2系統配電が基本となる。一般的なサーバーには電源ユニットが2個搭載されており、それぞれの電源ケーブルを異なる電源系統に接続する。いずれかの系統が停止しても、もう一つの系統からの電力供給により、各機器は支障なく稼働する仕組みである(図4)。

② 非常用発電機

停電に備え、データセンターでは非常用発電機を準備している。非常用発電機には、ディーゼル発電、ガスタービン発電、ガスエンジン発電の3種類があるが、ガスエンジン発電は小規模施設向けの製品であり、データセンターではディーゼル発電機とガスタービン発電機が主流である。

ディーゼル発電機は本体価格や燃料価格が安く、発電効率も良いという長所があるが、振動、騒音、煙の発生が短所である。一方のガスタービン発電機は、振動、騒音、煙は少ないが、本体価格や燃料価格が高く、発電効率も低いことが短所である。 ディーゼル発電機の燃料は軽油とA重油であり、ガスタービン発電機の燃料は天然ガスなども利用可能であるが、燃料備蓄の容易さなどから軽油やA重油を用いることも多い。東京圏のデータセンターでは24~48時間稼働できる程度の燃料を備蓄することが一般的である。

③UPS(無停電電源装置)

UPSとはUninterruptible Power Supply(またはUninterruptible Power Systems)の略で、無停電電源装置と訳される。バッテリー等を用い、外部電源が途絶えた際に非常用発電機が安定稼働状態になるまでの間、データセンター内の機器に電力を供給する装置である。UPSの持続時間はバッテリーの容量に依存するが、一般的には数分から数十分程度稼働できるように設計されている。

(4) 冷却設備

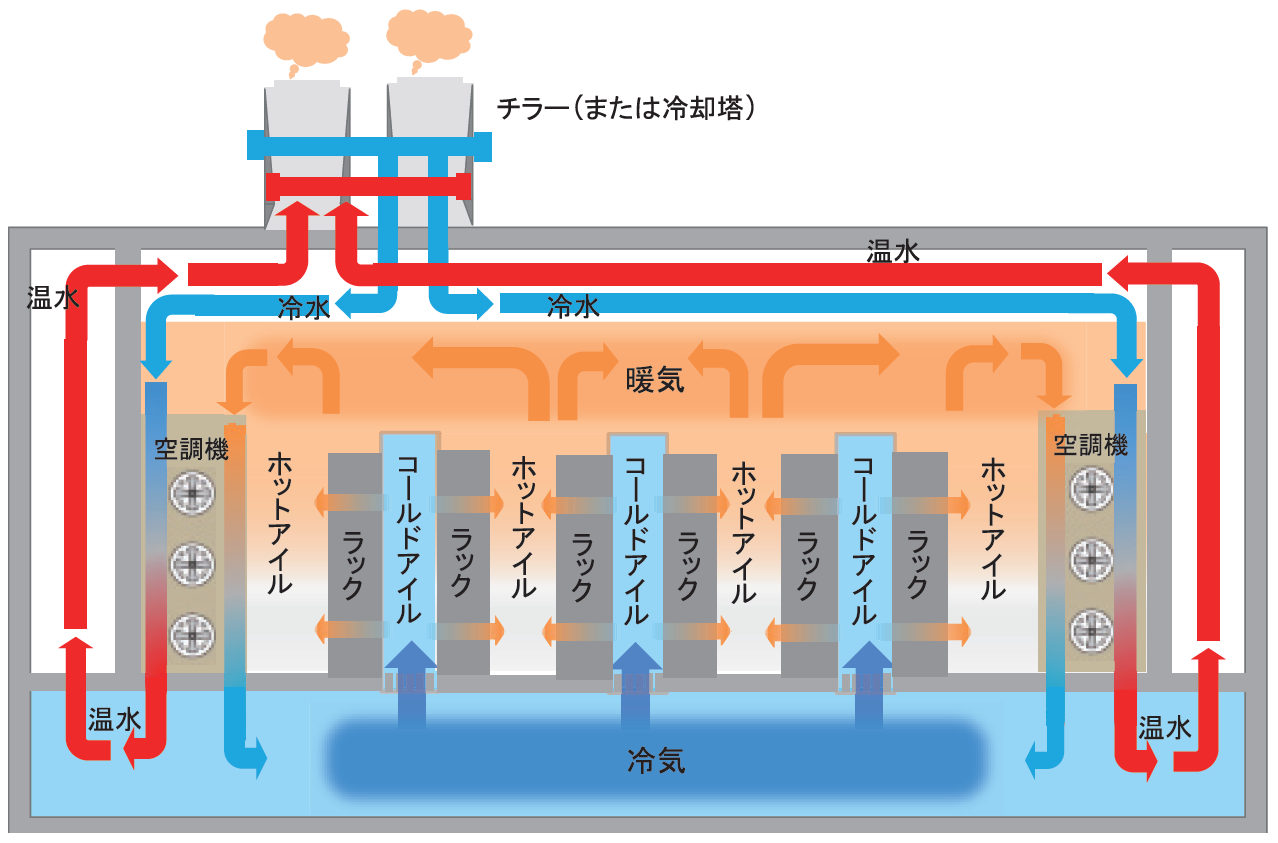

多くのデータセンターでは、冷たい空気をサーバーに吹き付けて冷やす「空冷方式」が採用されている。床下からサーバーの前面に向かって冷たい空気を送り、暖まった空気を天井で回収する方法が一般的である。室内機および屋外機(チラー注1)や冷却塔)により、回収した熱を建物外に放出する。

冷却効率向上のため、不燃性のカーテンやパネルで仕切り、暖気の通り道(ホットアイル)と冷気の通り道(コールドアイル)を区分するアイルコンテインメント注2)と呼ばれる対策が講じられる(図5)。

なお、GPU(画像処理装置)はこれまでのCPUよりさらに大量の電力を消費し、発熱量もより大きい。効率的に冷却する方法として「水冷(液冷)方式」が近年注目されており、後述することとする。

(5) 通信設備

データセンターの通信設備は、サーバーやストレージがインターネット網や専用回線を通じて外部接続するための機器およびネットワークケーブル(通信用の配線)である。MDF(Main Distribution Frame)室には、そのような通信設備が集約されている。

MDF自体は、集合住宅や一般のオフィスビルにも配置されているが、データセンターにおける設計上の特徴は、冗長性が考慮されている点である。外部から引き込まれるケーブルについてもルート分けがなされており、断線や障害のリスクを最小限に抑制するための仕組みとなっている。

MDF室から施設内の各フロア・各室に直接接続するとMDF室に敷設するケーブルが大量になり、メンテナンス上の支障ともなりえる。このため、各フロアに設置したIDF(Intermediate Distribution Frame)室を通じて各室に接続していることが多い。

3. データセンターの集中立地と電力消費

(1) 全世界

2025年4月、国際エネルギー機関(IEA; International Energy Agency)は報告書「Energy and AI」で、2024年時点のデータセンターの電力消費量が約4,150億kWh(キロワットアワー)となり、全世界の電力消費の約1.5%を占めたと推計した。さらに、2030年までに全世界の電力消費の約3.0%、約9,450億kWhへと倍増するとの見通しを示している。

データセンターの消費電力は全体の数パーセントに過ぎないが、立地は特定地域に集中しやすい。これは、データの需要地からの距離や、電力・通信インフラの充実等が重視されるためである。IEAは互いに100km以内にあるデータセンター群をクラスターと定義し、全世界の10大クラスターを特定している(図6)。

データセンターの集積地では、消費電力に占めるデータセンターの割合が局所的に高くなる。IEAの報告書によれば、アイルランドではデータセンターが電力供給の約20%を消費し、米国では既に六つの州で10%以上に達し、バージニア州では25%を消費しているとされている。

(2) 日本国内

人口減少や省エネの進展により、2007年度以降は電力需要が減少する傾向が続いていたが、最近の推計では将来的に増加に転じる見込みとなっている。電力広域的運営推進機関(OCCTO)の推計では、経済成長やデータセンター・半導体工場の新増設を要因として、2024年度から2034年度までの期間で年間の電力需要が465億kWh(うちデータセンターは440億kWh)増加すると予想されている。

ここまでお読みいただきありがとうございます。

以下のボタンをクリックしていただくとPDFにて全文をお読みいただけます(無料の会員登録が必要です)。

会員登録してPDFで全て読む

ご登録済みの方は

58114文字